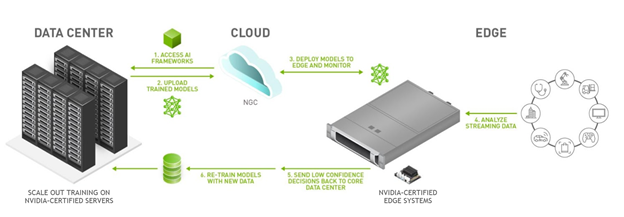

边缘AI(Edge AI)是当前人工智能技术发展的重要方向,它将AI算法直接部署在靠近数据生成源头的边缘设备上,实现本地数据处理与决策,而非依赖远程云端服务器。这种架构将智能下沉至设备端,解决了传统云端AI在带宽、延迟、隐私等方面的瓶颈,成为物联网、工业自动化和智能设备的关键技术。如老wu之前发表的博客文章《恩智浦(NXP)将以3.07亿美元收购边缘人工智能先锋企业Kinara》所述,各大厂商都在加大力度布局边缘AI市场,边缘 AI 近期已成为科技行业的热点领域,呈现快速发展态势。

什么是边缘AI

边缘AI结合了"边缘计算"与"人工智能"两大概念,其核心在于将AI模型(特别是推理部分)部署在终端设备上,如传感器、摄像头、工业控制器等。与传统AI不同,边缘AI直接在设备端完成推理,而训练则多在云端或高性能设备上进行。边缘设备通常资源受限,因此模型需要压缩至极小规模,有时甚至只有几十KB,在功耗与精度间取得平衡。

业界常用BLERP框架总结边缘AI的五大优势,即:带宽(Bandwidth)、延迟(Latency)、经济性(Economics)、可靠性(Reliability)以及往往被忽略而其实是非常重要的隐私(Privacy)方面。

对于带宽,边缘AI避免了传输大量原始数据,而仅上传预处理后的关键结果,可节省网络资源;延迟方面,数据直接在本地处理,消除了云端通信的延迟,适用于自动驾驶等要求高实时性的场景;经济性方面则体现在减少对云服务器的依赖,可降低基础设施建设成本,也能降低长期运营成本;可靠性方面,即使在网络连接不稳定或中断的情况下,边缘设备仍可以独立完成数据处理和决策,提高了系统的可靠性;隐私保护方面,边缘AI的数据直接在本地处理,而无需传输到云端,减少了数据泄露的风险,增强了私域数据的保护。

边缘AI与嵌入式系统

边缘AI与嵌入式系统有着紧密的依存关系。嵌入式系统是边缘AI的硬件载体,提供了物理基础和计算资源;而边缘AI则为嵌入式系统带来智能化升级,从简单的固定逻辑控制扩展到动态决策能力。两者在技术实现上相互协同,嵌入式系统需针对AI任务优化硬件,边缘AI算法也需适配嵌入式环境的资源限制。

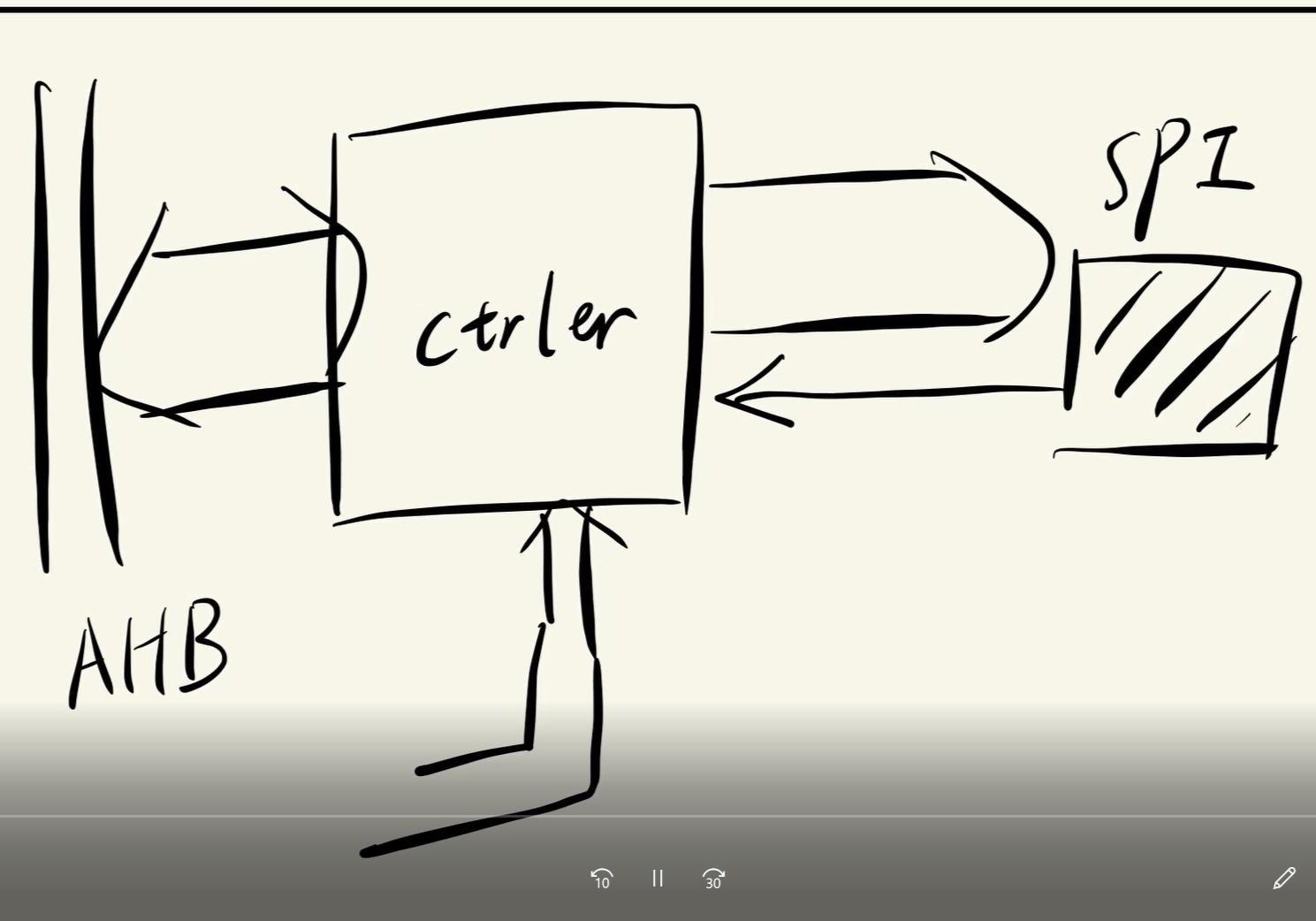

从硬件架构看,边缘AI设备通常采用异构计算设计,包括主处理器(如Arm Cortex系列)、专用加速单元(DSP、NPU或GPU)、传感器接口、分级存储架构和通信模块。根据应用场景和性能需求,边缘AI设备可分为三类:微控制器,适合超低功耗场景;SoC,平衡性能与功耗;边缘服务器,提供接近传统服务器的算力。

边缘AI的嵌入式硬件选型考量

边缘AI的数据主要来自设备内部传感器,包括加速度计、温湿度、麦克风、摄像头等。这些传感器采集物理世界信息,为AI模型提供输入。根据应用场景,边缘AI设备会使用不同类型的传感器:声学与振动传感器用于监测设备状态;视觉传感器实现目标检测;运动与位置传感器追踪物体移动;环境传感器监测周围条件变化。

开发边缘AI应用需要专门的工具链。端到端开发平台如Edge Impulse整合了数据标注、模型训练和部署功能;算法开发工具包括TensorFlow Lite和PyTorch等框架;嵌入式开发工具如Arduino IDE和STM32CubeIDE提供硬件支持。

处理器是边缘AI的核心组件,从低端MCU(如ESP32)到高端SoC(如瑞芯微RK3576),再到专用加速器(推理加速卡)各有所长。MCU功耗低但算力有限,适合简单分类任务;SoC支持复杂算法且集成丰富外设和NPU;DSP和深度学习加速器则提供专用计算能力,显著提升特定任务性能。选择处理器需平衡算力、功耗、成本和灵活性等因素。

SoC的核心优势在于其高度集成化的设计。它将CPU、GPU、NPU(神经网络处理单元)、内存控制器以及多种外设接口集成在同一芯片上,不仅减少了硬件体积和功耗,还提高了数据处理效率。例如,瑞芯微的RK3576 SoC,凭借其四核Cortex-A72大核和四核Cortex-A53小核的架构,以及6TOPS算力的独立NPU,能够在低功耗下实现高效的AI推理。这种设计使得RK3576在智能摄像头、物联网传感器和安防系统等边缘设备中表现出色。

开发板以及核心板在边缘AI开发中扮演关键角色,它们是连接算法验证与硬件落地的桥梁,提供快速原型验证、数据采集与功耗测试等功能。

扫码关注

扫码关注