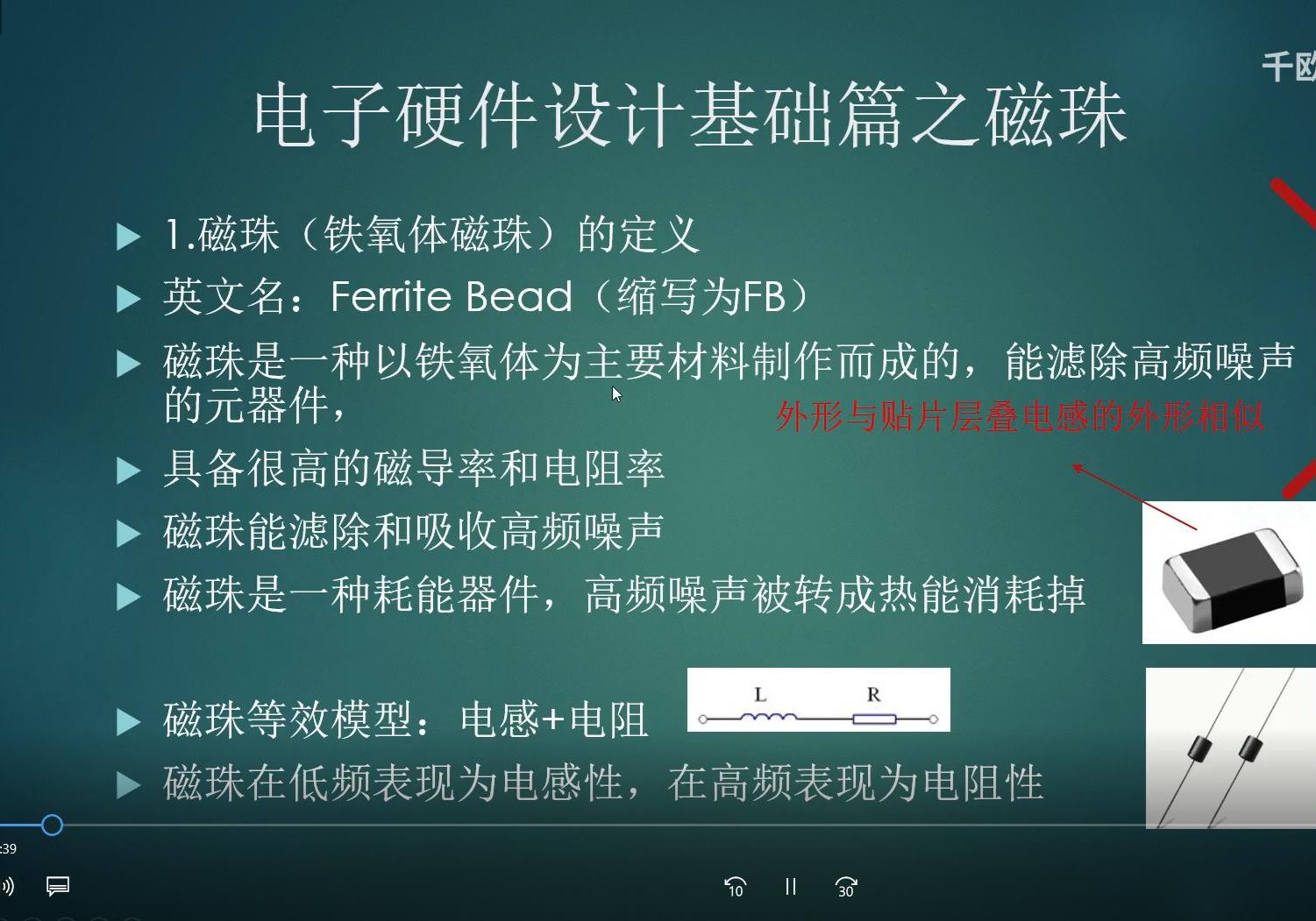

目前尚无正式的行业基准来定义消费级和数据中心GPU。不过,不同GPU产品之间存在硬件和处理速度差异,从而区分数据中心和基于PC的使用情况。

传统消费级GPU在64位浮点处理中最高可达0.38万亿次浮点运算(Tflops),而企业级Nvidia Tesla V100最高可达7.8万亿次浮点运算。每种GPU的架构、计算统一设备架构(CUDA)核心数量、内存带宽和整体功能都不同。

供应商根据使用情况和处理速度对GPU进行分类,因此应该确定需要GPU处理哪些工作负载,然后研究最佳选项。消费级GPU适用于带宽和功率要求较低的数据中心、测试软件或安装在现成的PC中。

但是,如果处理图像分类、大数据处理、物联网或机器学习,则应该研究高端GPU。如果服务器包含GPU扩展机箱,则可以最大化硬件投资,数据中心GPU卡可以为最苛刻的工作负载提供充足的图形处理能力。

管理员可以使用什么作为数据中心GPU?

管理员可以使用多种不同的GPU作为数据中心的计算资源,具体选择取决于数据中心的用途、预算以及所需的性能。以下是几种常见的数据中心GPU选项:

NVIDIA A100 Tensor Core GPU:

● 专为高性能计算(HPC)、深度学习和大规模数据分析而设计。

● 提供高达20 TFLOPS的FP32性能和640 Tensor TFLOPS的FP16性能。

● 支持多实例GPU(MIG)技术,可以将单个A100划分为多个独立的GPU实例。

NVIDIA V100 Tensor Core GPU:

● 适用于深度学习和高性能计算应用。

● 提供16GB或32GB的HBM2内存。

● 提供125TensorTFLOPS的性能。

NVIDIA T4 Tensor Core GPU:

● 适用于推理、训练、视频转码和虚拟桌面应用。

● 提供16GB的GDDR6内存。

● 能效高,适合大规模部署。

AMD Instinct MI100:

● 针对高性能计算和深度学习设计。

● 提供高达11.5TFLOPS的FP32性能和184TensorTFLOPS的FP16性能。

● 使用HBM2内存,提供高内存带宽。

Google TPU(Tensor Processing Unit):

● 专为机器学习工作负载设计,尤其是Google的TensorFlow框架。

● 提供高效的训练和推理性能。

● 主要在Google Cloud Platform上提供。

Intel Habana Gaudi和Goya加速器:

● Gaudi主要用于深度学习训练。

● Goya主要用于深度学习推理。

● 提供高效的计算和内存带宽。

在选择数据中心GPU时,管理员需要考虑以下因素:

计算性能:不同的工作负载对计算性能的要求不同,比如深度学习训练需要高计算性能,而推理可能更关注能效。

内存带宽和容量:某些工作负载(如大型数据集的处理)需要高内存带宽和大容量内存。

扩展性:数据中心的规模和未来扩展需求。

兼容性和生态系统:所选GPU是否兼容现有的软件堆栈和硬件基础设施。

成本:包括初始采购成本和运行成本(例如功耗)。

这些GPU各有优劣,具体选择应根据数据中心的具体需求进行权衡。

此文内容来自千家网,如涉及作品内容、版权和其它问题,请于联系工作人员,我们将在第一时间和您对接删除处理!

扫码关注

扫码关注