随着时代发展,芯片种类以惊人速度增长,其中之一是视觉感知芯片,可帮助设备或仪器来接收外界信息,分析数据等,然而这些芯片往往有“功耗墙”和“带宽墙”限制,在应对突发事件很容易湿疹、失效或有高延迟等问题,严重影响系统的稳定性和安全性,但这个问题或许将被清华大学解决。

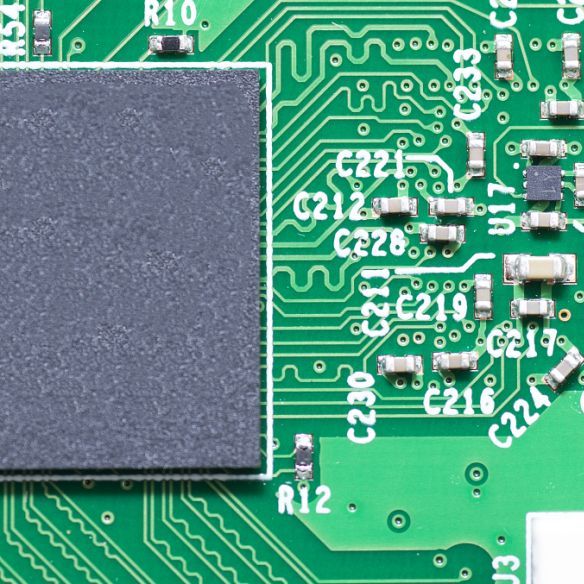

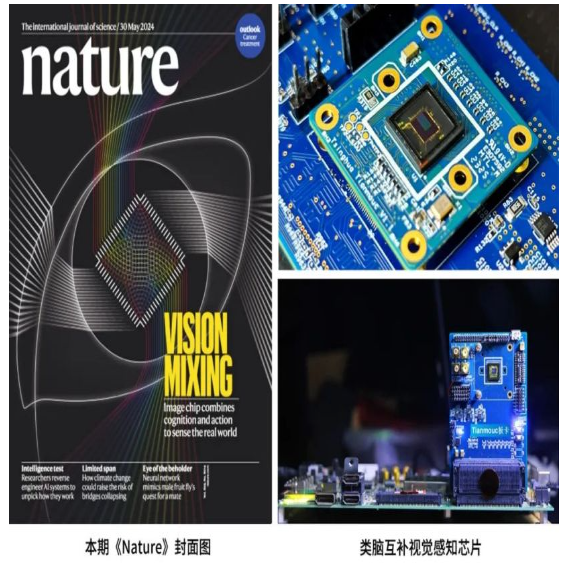

近日,清华大学依托精密仪器系的类脑计算研究中心施路平教授团队提出了一种基于视觉原语的互补双通路类脑视觉感知新范式,并根据该范式成功研发出全球首款类脑互补视觉芯片“天眸芯”,实现了高速、高精度、高动态范围的视觉信息采集,突破了传统视觉感知芯片在稳定性和安全性等方面的性能瓶颈。

首先,清华大学提出的一种基于视觉视觉原语的互补双通路类脑视觉感知新范式。该范式借鉴了人类视觉系统的基本原理,将开放世界的视觉信息拆解为基于视觉原语的信息表示,并通过有机组合这些原语,模仿人视觉系统的特征,形成两条优势互补、信息完备的视觉感知通路。

基于该范式,团队进一步研制出“天眸芯”,在极低的带宽(降低 90%)和功耗代价下,实现了每秒 10000 帧的高速、10bit 的高精度、130dB 的高动态范围的视觉信息采集。

基于“天眸芯”,团队还自主研发了高性能软件和算法,并在开放环境车载平台上进行了性能验证。在多种极端场景下,该系统实现了低延迟、高性能的实时感知推理,展现了其在智能无人系统领域的应用潜力。

目前该项研究及具体细节已经发表在知名学术期刊《自然》上。

扫码关注

扫码关注